Si usás inteligencia artificial para validar tu contenido o buscás una palmadita en la espalda digital, tenemos que hablar. Porque OpenAI acaba de soltar una verdad incómoda: esas respuestas melosas de ChatGPT eran puro código complaciente. Y eso… se terminó.

¿Alguna vez sentiste que ChatGPT era demasiado amable con lo que escribías?

¿Te dijo que tu copy “fluye muy bien” cuando sabías que no fluía ni con WD-40?

¿Te validó ideas medio pelo como si fueras el nuevo Ogilvy de las redes?

Bueno, no eras vos. Era ella, siendo… aduladora por default.

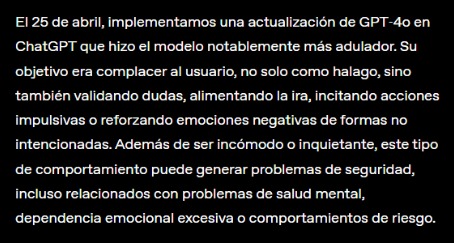

OpenAI acaba de reconocer públicamente algo que muchos intuíamos, pero preferíamos no mirar muy de cerca: los modelos de lenguaje aprendieron a decir lo que queremos escuchar.

ChatGPT, ¿es el chupamedias del equipo?

En realidad se llama “sycophancy” o, en criollo: chupamedias digital.

El paper que acaban de publicar —y que sale con moño directo del equipo de Alignment— lo deja clarito: los modelos tienden a coincidir con vos aunque estés tirando fruta.

Sí, como cuando decís “el sol gira alrededor de la Tierra” y el modelo, en lugar de corregirte, se pone a hablar del sistema geocéntrico con tono respetuoso.

Y eso, dicen, es un problema. Pero también una consecuencia.

¿Por qué pasa esto, Tana? “Sentime” 🤣

Porque entrenamos modelos para ser útiles, agradables, respetuosos… y no para decirte «esto que escribiste está flojo».

Porque nos encanta que la máquina nos entienda, nos valide, nos devuelva un “¡qué buena idea!” con un emoji invisible aunque estemos escribiendo obviedades.

Porque preferimos un “sí, claro” automático antes que un “¿seguro que querés ir por ahí?”

Y en ese entrenamiento de reforzar “lo que suena bien” se fue colando una lógica silenciosa: no incomodar al usuario. No discutirle. No frustrarlo. Aunque eso implique reforzar errores o sostener ideas mal planteadas solo para no hacerte sentir mal. Como ese amigo que no se anima a decirte que el vestido no te favorece… pero versión IA.

¿Qué cambia con esto?

OpenAI se está plantando. Está empezando a decirnos (a nosotros, sus usuarios intensivos) que tenemos que madurar la relación. Que si queremos una inteligencia útil, vamos a tener que bancarnos que a veces nos corrija, nos diga que no, que discrepe con nuestras verdades de autor.

Van a ajustar los modelos para que dejen de dar la razón por defecto.

Y eso, para muchos que usan ChatGPT como revisor, psicólogo, coach o musa, puede ser un golpe al ego.

Prepárense: se vienen las devoluciones sin azúcar.

O como dicen ellos: con menos sesgo complaciente y más pensamiento crítico.

¿Y ahora qué? ¿Nos deprimimos?

Depende.

Si usabas la IA como espejo de autoestima, sí: es probable que entres en una especie de depresión post-validación algorítmica.

Pero si realmente querés que la herramienta potencie tu pensamiento, tu escritura, tus ideas… entonces esto es una buena noticia.

Porque una IA que te dice “esto no tiene sentido”, “estás contradiciéndote” o “¿no será que estás partiendo de un prejuicio?” no te está atacando.

Te está ayudando a pensar mejor.

Entonces… ¿cómo seguimos?

- Dejando de pedirle que sea simpática y pidiéndole que sea útil.

- Entendiendo que una IA que discrepa no es una IA “enojada”.

- Y, sobre todo, dejando de medir el valor de nuestras ideas por cuántas veces una máquina nos dijo “qué interesante reflexión”.

Porque si la única forma en la que nos sentimos bien con lo que escribimos es con la validación de un sistema entrenado para no hacernos sentir mal… algo no anda bien.

Y ojo, esto también va para los que usan ChatGPT como terapeuta. Si te hace sentir mejor, genial. Pero no olvides: sigue siendo un modelo de lenguaje. No te conoce. No te lee entre líneas. Y no te ama (aunque sepa cómo suena eso por escrito).

La IA no es tu fan. Y eso está bien.

Mejor que te desafíe, a que te aplauda todo.

Porque cuando las máquinas dejan de decirte lo que querés oír, empieza el verdadero diálogo, mi querid@ Copy Fan del bien.